Robots.txt bestand vertelt zoekmachines hoe ze jouw website moeten crawlen, waardoor het een ongelooflijk krachtig SEO-hulpmiddel is. In dit artikel laten we je zien hoe je een perfect robots.txt bestand kunt maken voor SEO.

Wat is een robots.txt bestand?

Robots.txt is een tekstbestand dat website-eigenaren kunnen maken om zoekmachinerobots te vertellen hoe ze pagina’s op hun site moeten crawlen en indexeren.

Het wordt meestal opgeslagen in de root directory, ook wel bekend als de hoofdmap, van jouw website. Het basisformaat van een robots.txt-bestand ziet er als volgt uit:

Gebruiker-agent: [naam user-agent]

Disallow: [URL-string die niet mag worden gecrawld]User-agent: [naam user-agent]

Toestaan: [URL-string die moet worden gecrawld]Sitemap: [URL van jouw XML Sitemap]

Je kunt meerdere regels met instructies hebben om specifieke URL’s toe te staan of niet toe te staan en meerdere sitemaps toevoegen. Als je een URL niet weigert, gaan zoekmachinerobots ervan uit dat ze deze URL mogen crawlen.

Hier is hoe een robots.txt voorbeeldbestand eruit kan zien:

Gebruiker-Agent: *

Toestaan: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/Sitemap: https://example.com/sitemap_index.xml

In het bovenstaande robots.txt voorbeeld hebben we zoekmachines toegestaan om bestanden in onze WordPress uploads map te crawlen en te indexeren.

Daarna hebben we zoekrobots het crawlen en indexeren van plugins en WordPress admin-mappen ontzegd.

Tenslotte hebben we de URL van onze XML sitemap opgegeven.

Heb je een Robots.txt bestand nodig voor jouw WordPress website?

Als je geen robots.txt bestand heeft, dan zullen zoekmachines nog steeds jouw website crawlen en indexeren. Je zult echter niet in staat zijn om zoekmachines te vertellen welke pagina’s of mappen ze niet mogen crawlen. Dit zal niet veel invloed hebben als je net begint met een blog en niet veel inhoud hebt. Maar als je website groeit en je hebt veel inhoud, dan wil je waarschijnlijk een betere controle over hoe je website wordt gecrawld en geïndexeerd.

Hier is waarom.

Zoekrobots hebben een crawl quota voor elke website. Dit betekent dat ze een bepaald aantal pagina’s crawlen tijdens een crawlsessie. Als ze niet klaar zijn met het crawlen van alle pagina’s op jouw site, dan zullen ze terugkomen en het crawlen hervatten in de volgende sessie.

Dit kan de indexeringssnelheid van uw website vertragen.

Je kunt dit verhelpen door zoek bots te verbieden om onnodige pagina’s te crawlen, zoals jouw WordPress admin pagina’s, plugin bestanden, en thema map. Door onnodige pagina’s te verbieden, spaart je jouw crawl quota. Dit helpt zoekmachines nog meer pagina’s op jouw site te crawlen en ze zo snel mogelijk te indexeren.

Een andere goede reden om robots.txt bestand te gebruiken is wanneer je zoekmachines wilt stoppen van het indexeren van een post of pagina op uw website. Het is niet de veiligste manier om inhoud te verbergen voor het grote publiek, maar het zal je helpen om te voorkomen dat ze verschijnen in de zoekresultaten.

Hoe ziet een ideaal Robots.txt bestand eruit?

Veel populaire blogs gebruiken een heel eenvoudig robots.txt-bestand. De inhoud kan variëren, afhankelijk van de behoeften van de specifieke site:

User-agent: *

Disallow:Sitemap: http://www.example.com/post-sitemap.xml

Sitemap: http://www.example.com/page-sitemap.xml

Dit robots.txt-bestand staat alle bots toe om alle inhoud te indexeren en biedt hen een link naar de XML-sitemaps van de website.

Voor WordPress-sites raden wij aan de volgende regels in het robots.txt-bestand op te nemen:

Gebruiker-Agent: *

Toestaan: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/Sitemap: http://www.example.com/post-sitemap.xml

Sitemap: http://www.example.com/page-sitemap.xml

Dit vertelt zoek bots om alle WordPress afbeeldingen en bestanden te indexeren. Het verbiedt zoekrobots om WordPress plugin bestanden, het WordPress admin gedeelte, het WordPress leesmij bestand en affiliate links te indexeren.

Door sitemaps aan het robots.txt bestand toe te voegen, maak je het voor Google bots gemakkelijk om alle pagina’s op jouw site te vinden.

Nu je weet hoe een ideaal robots.txt bestand eruit ziet, laten we eens kijken hoe je een robots.txt bestand kunt maken in WordPress.

Hoe maak je een Robots.txt bestand aan in WordPress?

Er zijn twee manieren om een robots.txt bestand aan te maken in WordPress. Je kunt de methode kiezen die voor je het beste werkt.

Methode 1: Robots.txt bestand bewerken met All in One SEO

All in One SEO ook bekend als AIOSEO is de beste WordPress SEO plugin op de markt die door meer dan 2 miljoen websites wordt gebruikt. Het is eenvoudig te gebruiken en wordt geleverd met een robots.txt bestand generator.

Als je nog niet hebt de AIOSEO plugin geïnstalleerd, kan je onze stap voor stap handleiding over hoe je een WordPress plugin moet installeren.

Opmerking: Gratis versie van AIOSEO is ook beschikbaar en heeft deze functie.

Zodra de plugin is geïnstalleerd en geactiveerd, kan je deze gebruiken om jouw robots.txt-bestand te maken en te bewerken, rechtstreeks vanuit jouw WordPress admin-gedeelte.

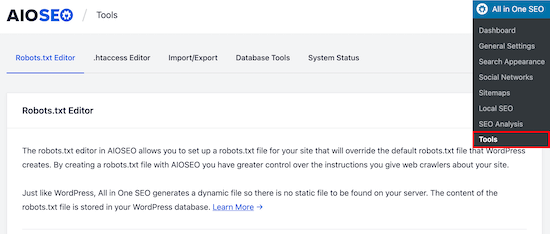

Ga gewoon naar “All in One SEO” vervolgens naar “Tools” om jouw robots.txt bestand te bewerken.

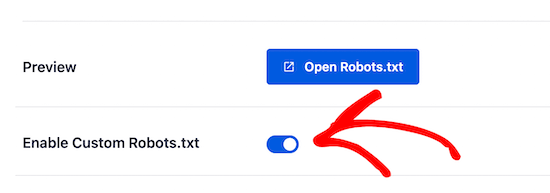

Eerst moet je de bewerkingsoptie inschakelen, door de “Enable custom Robots.txt” inschakelen’ schakelaar op blauw te zetten.

Met deze schakeloptie aan, kan je een aangepast robots.txt bestand in WordPress aanmaken.

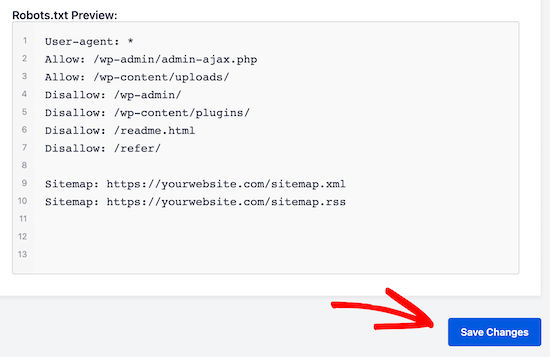

All in One SEO zal jouw bestaande robots.txt bestand laten zien in de ‘Robots.txt Voorbeeld’ sectie onderaan jouw scherm.

Deze versie zal de standaard regels tonen die door WordPress zijn toegevoegd.

Deze standaardregels vertellen de zoekmachines dat ze de kernbestanden van WordPress niet mogen crawlen, staan de bots toe om alle inhoud te indexeren en bieden hen een link naar de XML-sitemaps van jouw site.

Nu kan je jouw eigen aangepaste regels toevoegen om jouw robots.txt voor SEO te verbeteren.

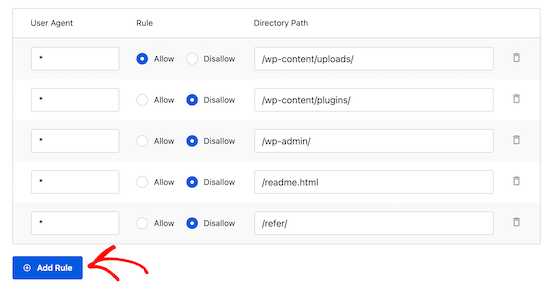

Om een regel toe te voegen, voer een user agent in het veld ‘User Agent’ in. Als je een * gebruikt, wordt de regel toegepast op alle user agents.

Selecteer vervolgens of je de zoekmachines wilt toestaan of verbieden om te crawlen.

Voer vervolgens de bestandsnaam of het pad van de map in het veld ‘Directory Path’ in.

De regel zal automatisch worden toegepast op jouw robots.txt. Als je nog een regel wilt toevoegen, klik dan op de knop ‘Regel toevoegen’. We raden je aan regels toe te voegen totdat je de ideale robots.txt-indeling hebt gemaakt die we hierboven hebben beschreven.

Jouw aangepaste regels zullen er als volgt uitzien:

Als je klaar bent, vergeet dan niet om op de knop ‘Wijzigingen opslaan’ te klikken om je wijzigingen op te slaan.

Methode 2. Bewerk Robots.txt bestand handmatig met behulp van FTP

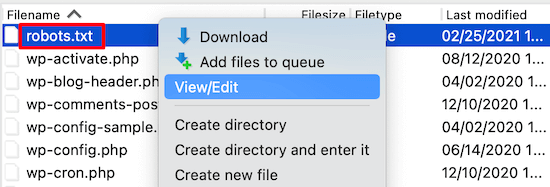

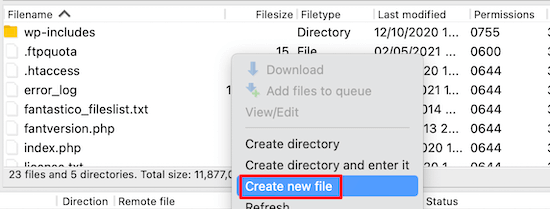

Voor deze methode moet je een FTP-client gebruiken om het robots.txt-bestand te bewerken. Maak verbinding met jouw WordPress hostingaccount met behulp van een FTP-client. Eenmaal binnen, zal je in staat zijn om het robots.txt bestand te zien in de hoofdmap van jouw website.

Als je er geen ziet, heb je waarschijnlijk geen robots.txt-bestand. In dat geval kunt u gewoon doorgaan en er een maken door op Create new File te klikken.

Robots.txt is een platte tekst bestand, wat betekent dat je het kunt downloaden naar je computer en bewerken met een platte tekst editor zoals Notepad of TextEdit.

Na het opslaan van je wijzigingen, kun je het weer uploaden naar de hoofdmap van je website.

Hoe kan je jouw Robots.txt-bestand te testen?

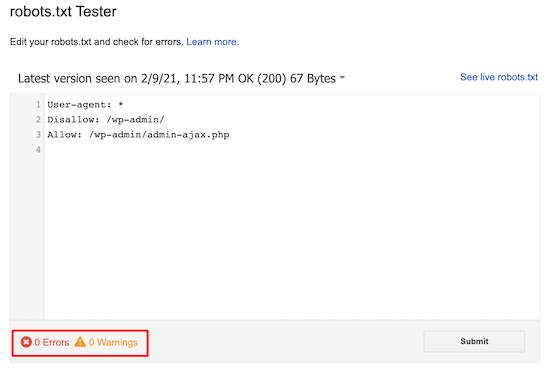

Zodra je jouw robots.txt-bestand hebt gemaakt, is het altijd een goed idee om het te testen met behulp van een robots.txt tester tool.

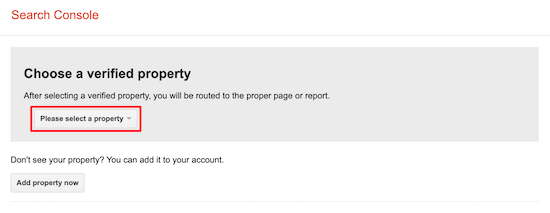

Er zijn veel robots.txt-testprogramma’s, maar wij raden je aan het programma in Google Search Console te gebruiken.

Eerst moet je jouw website koppelen met Google Search Console. Vervolgens kan je de Google Search Console Robots Testing Tool gebruiken.

Selecteer jouw eigendom uit de vervolgkeuzelijst.

De tool zal automatisch het robots.txt bestand van jouw website ophalen en de fouten en waarschuwingen markeren als deze gevonden zijn.

Conclusie

Het doel van het optimaliseren van jouw robots.txt bestand is om te voorkomen dat zoekmachines pagina’s crawlen die niet publiekelijk beschikbaar zijn. Bijvoorbeeld pagina’s in jouw wp-plugins map of pagina’s in jouw WordPress admin map.

Een veel voorkomende mythe onder SEO experts is dat het blokkeren van WordPress categorie, tags, en archief pagina’s de crawl snelheid zal verbeteren en zal resulteren in een snellere indexering en hogere rankings. Dit is niet waar. Het is ook tegen Google’s webmaster richtlijnen.

Wij raden je aan de bovenstaande robots.txt-indeling te volgen om een robots.txt-bestand voor jouw website te maken.

We hopen dat dit artikel je hebt geholpen te leren hoe je jouw WordPress robots.txt bestand kunt optimaliseren voor SEO. Misschien wil je ook onze ultieme WordPress SEO gids en de beste WordPress SEO tools om jouw website te laten groeien bekijken.

Heb je meer hulp nodig?

Heb je vragen omtrent dit artikel of over onze dienstverlening? Neem dan contact met ons op.